Pre-Act ResNet, 2016

Pre-Act ReNet은 2016년 CVPR에 발표된 "Identify Mappings in Deep Residual Networks" 논문에서 제안된 architecture임. Pre-Act는 Pre-Activation의 약자로, Residual Unit을 구성하고 있는 Conv-BN-ReLu 연산에서 Activation function인 ReLu를 Conv 연산 앞에 배치한다고 해서 붙여진 이름임. ResNet을 제안한 Microsoft Research 멤버가 그대로 유진된채 작성한 후속 논문이며 ResNet의 성능을 개선하기 위해 여러 실험을 수행한 뒤, 이를 분석하는 식으로 설명하고 있음.

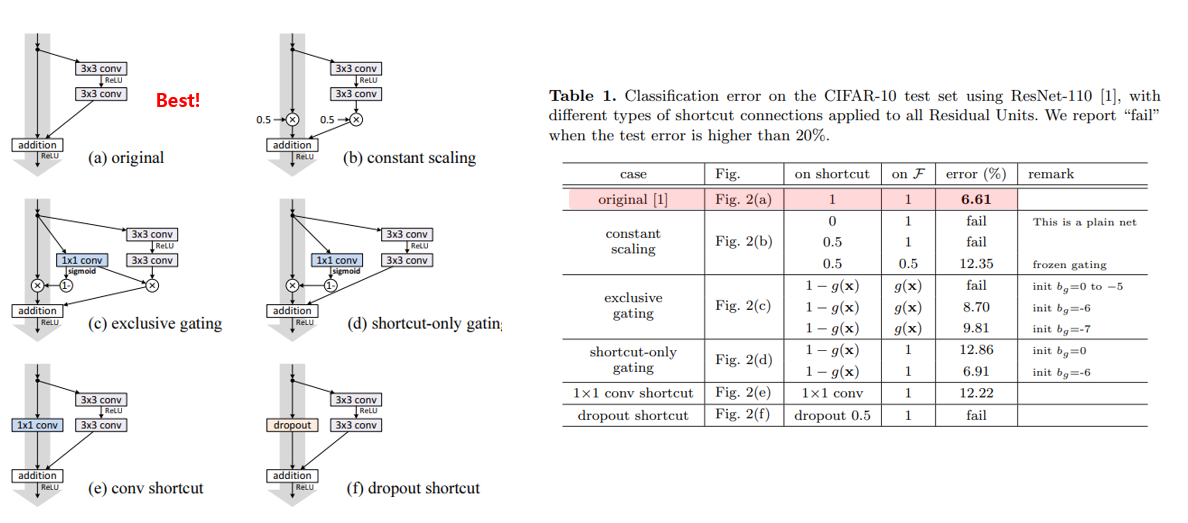

우선 기존 ResNet에서 사용되던 Identity shortcut을 5가지 다양한 shortcut으로 대체하는 방버과, 각각을 적용하였을 때의 실험 결과를 확인할 수 있는데, 실험결과 아무것도 하지 않았을때(Identity shortcut 상태) 가장 성능이 좋은 것을 확인할 수 있음. 이에 대한 discussion으로, 제안하는 gating 기법과 1x1 conv 등을 추가하면 표현력(representational ability)은 증가하지만 학습 난이도를 높여서 최적화하기 어렵게 만다는 것으로 추정된다고 설명하고 있음.

Activation funtion의 위치에 따른 test error 결과로, 기존엔 Conv-BN-ReLU-BN을 거친 뒤 shorcut과 더해주고 마지막으로 ReLU를 하는 방식이었는데, 총 4가지 변형된 구서조를 제안하였고, 그중 full pre-activation 구조일 때 가장 test error가 낮았고, 전반적인 학습 안정성도 좋아지는 결과를 보인다고 함. Original 의 경우 2번째 BN을 거쳐서 feature map이 normalie되어도 shorcut과 더해지면서 다시 unnormalized된 채로 다음 Conv 연산으로 전달 되는 반면, 제안한 full pre-activation 구조는 모든 Conv 연산에 normalized input이 전달되기 때문에 좋은 성능이 관찰되는 것이라고 분석 하고 있음

출처: https://hoya012.github.io/blog/deeplearning-classification-guidebook-2/

Deep Learning Image Classification Guidebook [2] PreActResNet, Inception-v2, Inception-v3, Inception-v4, Inception-ResNet, Stoch

딥러닝을 이용한 Image Classification 연구들을 시간 순으로 정리하여 가이드북 형태로 소개드릴 예정입니다. 2편에서는 2016년 공개된 주요 CNN architecture들을 소개 드릴 예정입니다.

hoya012.github.io

'데이터사이언스 > 딥러닝' 카테고리의 다른 글

| Classification Project (Colab) (0) | 2022.07.25 |

|---|---|

| Object Detection Tensorflow API (Colab) #2_모델학습 (0) | 2022.07.18 |

| Object Detection Tensorflow API (Colab) #1_사전작업 (0) | 2022.07.18 |

| Image Labeling (0) | 2022.07.18 |

| LeNet, AlexNet, ZFNet, VGG, GoogLeNet, ResNet (0) | 2022.06.23 |